اخلاق خودکار: چالشهای اخلاقی در اتوماسیون و هوش مصنوعی

در عصر دیجیتال و پیشرفتهای شگرف فناوری، اتوماسیون و هوش مصنوعی به عنوان دو نیروی محرکه اصلی در تحول زندگی بشر معرفی شدهاند. اما در این دنیای نوین، سوالات پیچیده و چالشبرانگیزی در زمینه اخلاق و مسئولیتپذیری مطرح میشود. آیا میتوانیم به ماشینها اجازه دهیم که در تصمیمگیریهای حیاتی ما دخالت کنند؟ و در کجا باید خط قرمز را بکشیم تا از عواقب ناخواسته جلوگیری کنیم؟ این مقاله به بررسی این مسائل حیاتی میپردازد و تلاش میکند تا تعادل میان پیشرفت فناوری و اصول اخلاقی را کشف کند.

فیلسوف فرانسوی پل ویریلیو بر این باور است که توسعه فناوری به طور جداییناپذیری با مفهوم حادثه گره خورده است. او میگوید: “هر حادثهای یک معجزه معکوس است… وقتی کشتی را اختراع میکنید، در واقع کشتیشکنی را نیز اختراع کردهاید؛ وقتی هواپیما را خلق میکنید، سقوط هواپیما را نیز به وجود آوردهاید؛ و وقتی برق را اختراع میکنید، برقگرفتگی را نیز به همراه دارد.” حوادث نقاط عطفی هستند که نشان میدهند پیشبینی با واقعیت تلاقی کرده و نتیجهای ناخوشایند به بار آورده است. اما هر حادثه همچنین فرصتی برای آشکارسازی دنیوی و فراتر رفتن از گذشته است: فرصتی برای بهبود وضعیت فردا نسبت به امروز و گاهی اوقات وعدهای برای “هرگز دوباره نه”.

این، حداقل، نقشه راه ماست. اما وعده “هرگز دوباره نه” وعدهای دشوار برای حفظ است: در درازمدت، سوال این نیست که آیا چیزی اشتباه میرود، بلکه این است که چه زمانی این اتفاق خواهد افتاد. به همین دلیل، نگرانیهای اخلاقی در نوآوری معمولاً بر کاهش و تخفیف آسیب تمرکز دارند، نه بر حذف کامل آن. یک کشتی بخار با بدنه دوگانه، خطر کمتری را به ازای هر مسافر نسبت به یک کشتی تجاری قرون وسطایی به همراه دارد؛ یک کارخانه به خوبی مدیریت شده ایمنتر از یک کارگاه استثمارگر است. اگرچه سقوط هواپیماها ممکن است جان بسیاری را بگیرد، اما تدابیری مانند چکلیست، کامپیوتر و کمکخلبان در برابر تقریباً همه شرایط پیشبینینشده، ایمنی ایجاد میکنند.

تدابیر مشابه موضوع یکی از داغترین مباحث در اخلاق عملی امروز است: خودروهای خودران. وسایل نقلیه مدرن ایمنتر و قابلاعتمادتر از هر زمان دیگری هستند، با این حال، بیش از 1 میلیون نفر در سال در تصادفات جادهای جان خود را از دست میدهند و بیش از 50 میلیون نفر مجروح میشوند. چرا؟ عمدتاً به این دلیل که یک عنصر خطرناک در مکانیک رانندگی هنوز به کمال نرسیده است: انسان..!

در این راستا، به لبه برش فناوری کاهش آسیب میرسیم. در آگوست 2012، گوگل اعلام کرد که در آزمایش خودروهای خودران خود به 300,000 مایل بدون تصادف دست یافته است. این فناوری هنوز فاصله زیادی تا ورود به بازار دارد، اما شواهد آماری برای وسایل نقلیه خودکار بسیار قانعکننده است. حتی زمانی که خودروهای کنترل شده توسط انسان باعث آسیب نمیشوند، اغلب به طور ناکارآمد، ناشیانه و ضد اجتماعی رانده میشوند و به رنج انسانی میافزایند.

اما در مورد موقعیتهای محلی چه میتوان گفت؟ اگر وسیله نقلیه شما با اتوبوسی پر از دانشآموزان که ناگهان از جاده عبور میکنند، مواجه شود، آیا میخواهید در دنیایی زندگی کنید که خودرو به طور خودکار منحرف میشود و با سرعتی که هرگز نمیتوانستید کنترل کنید، آنها را نجات میدهد، در حالی که جان شما را به خطر میاندازد؟ یا ترجیح میدهید در دنیایی زندگی کنید که خودرو منحرف نشود و شما را در امان نگه دارد؟ اگر به این شکل مطرح شود، هیچکدام گزینه جذابی به نظر نمیرسد. با این حال، طراحی سیستمهای خودکفا ایجاب میکند که ما به این سوالات پاسخ دهیم. و این پرسشها ما را به یکی از قدیمیترین آزمایشهای فکری در فلسفه مدرن میکشاند: مشکل ترالی.

مسئله ترالی، که در سال 1967 توسط فیلسوف انگلیسی فیلیپا فوت مطرح شد، به بررسی چالشهای اخلاقی در تصمیمگیری میپردازد. در این سناریو، راننده یک تراموای بیسرپرست به سمت یک خط آهن در حال حرکت است. پنج مرد در این خط کار میکنند و به طور قطع با رسیدن تراموا جان خود را از دست خواهند داد. خوشبختانه، راننده میتواند مسیر تراموا را به یک خط فرعی تغییر دهد و جان همه پنج نفر را نجات دهد. اما متأسفانه، یک مرد دیگر در این خط فرعی مشغول کار است و اگر تغییر مسیر انجام شود، او کشته خواهد شد

در این نسخه اصلی، تصمیمگیری آسان به نظر میرسد: راننده باید مسیر را تغییر دهد و جان پنج نفر را نجات دهد، حتی به قیمت یک جان. اگر راننده را با یک برنامه کامپیوتری جایگزین کنیم، به این برنامه نیز دستور میدهیم که در هر موقعیت مشابه، تعداد کمتری را به قتل برساند. ممکن است ما ترجیح دهیم که یک برنامه این تصمیم را بگیرد، زیرا این برنامه همیشه بر اساس منطق عمل میکند در حالی که یک انسان ممکن است دچار وحشت شود.

مسئله ترالی در نسخههای مختلف خود جالبتر میشود. در مقالهای که در سال 1985 منتشر شد، فیلسوف MIT، جودیت جارویس تامسون، سناریویی دیگر را مطرح میکند: به جای اینکه راننده یک تراموای بیسرپرست باشید، از روی یک پل به تماشای آن مینشینید که به سمت پنج نفر بیدفاع در حال حرکت است. تنها راه متوقف کردن آن، استفاده از یک وزنه سنگین است و شما در کنار یک

مرد بزرگ ایستادهاید. آیا باید این مرد را از روی پل هل بدهید و او را به قتل برسانید تا جان پنج نفر را نجات دهید؟

یک برنامه کامپیوتری مشابه با آنچه که تراموای اول را هدایت میکند، در حل این مسئله مشکلی نخواهد داشت. در واقع، این برنامه هیچ تفاوتی بین این دو مورد نمیبیند. اما وقتی با مسئله ترالی تامسون مواجه میشوند، بسیاری از مردم احساس میکنند که هل دادن مرد چاق به سمت مرگش نادرست است. آنها استدلال میکنند که قتل از پیش برنامهریزی شده ذاتاً نادرست است، صرف نظر از نتایج آن.

هل دادن کسی به سمت مرگ با دستان خود از نظر روانی بسیار مشکلساز است، حتی اگر بپذیریم که از نظر نظری هیچ تفاوتی با کشتن او از فاصله 10 مایلی ندارد. در عین حال، اجازه دادن به کسی در فاصله دور – مثلاً یک کودک گرسنه در کشور دیگری – تا به خاطر عدم اقدام شما بمیرد، به نظر میرسد که به سختی احساس عذاب وجدان ایجاد میکند. همانطور که فیلسوفانی مانند پیتر سینگر به طرز قانعکنندهای استدلال کردهاند، سخت است که ببینیم چرا باید این را بپذیریم.

تصمیم بگیرید که تراموا را منحرف کنید تا جان پنج نفر را نجات دهید، نیت اصلی شما نجات جانهاست. حتی اگر یک مرگ به عنوان اثر ثانویه اجتنابناپذیر باشد، عمل شما در مقایسه با قتل از پیش برنامهریزی شده در یک دسته متفاوت قرار میگیرد.

آموزه اثر دوگانه به حسی اشاره دارد که اکثر مردم و سیستمهای قانونی با آن همنظرند: برنامهریزی برای کشتن کسی و سپس انجام آن، نادرستتر از کشتن او به طور تصادفی است. با این حال، یک سوال دشوار باقی میماند: تا چه حد میتوان به شهود و نیتهای انسانی اعتماد کرد؟ دیوید ادموندز در کتاب جدیدش با عنوان “آیا شما مرد چاق را خواهید کشت؟” (2013) به بررسی این موضوع میپردازد و بیان میکند که رشتهای از علوم نوظهور شروع به طرح ادعاهایی در این زمینه کردهاند. برای جاشوا گرین، روانشناس و مدیر آزمایشگاه شناخت اخلاقی دانشگاه هاروارد، آموزه اثر دوگانه بیشتر به عنوان یک توجیه پس از وقوع تلقی میشود تا یک بینش بنیادی.

در کتاب جدیدش با عنوان “قبیلههای اخلاقی” (2013)، گرین اذعان میکند که تقریباً همه افراد احساس نادرستی غریزی در مورد استفاده از زور شخصی برای آسیب رساندن به دیگران دارند. او این حس اخلاقی غریزی را مهم میداند، اما به هیچ وجه کامل نیست؛ این حس نوعی عملکرد عمیق مغزی است که به سختی میتوان انتظار داشت با پیشرفتهای تمدنی همگام شود. گرین پیشنهاد میکند که انسانها مانند دوربینها هستند و دو حالت اخلاقی دارند: خودکار و دستی. احساسات ما «فرآیندهای خودکار هستند… ابزارهایی برای دستیابی به کارایی رفتاری» که به ما اجازه میدهند به طور مناسب به برخوردهای روزمره پاسخ دهیم.

در عین حال، استدلال ما معادل حالت «دستی» است: «توانایی کار کردن به طور عمدی بر روی مسائل پیچیده و نو».

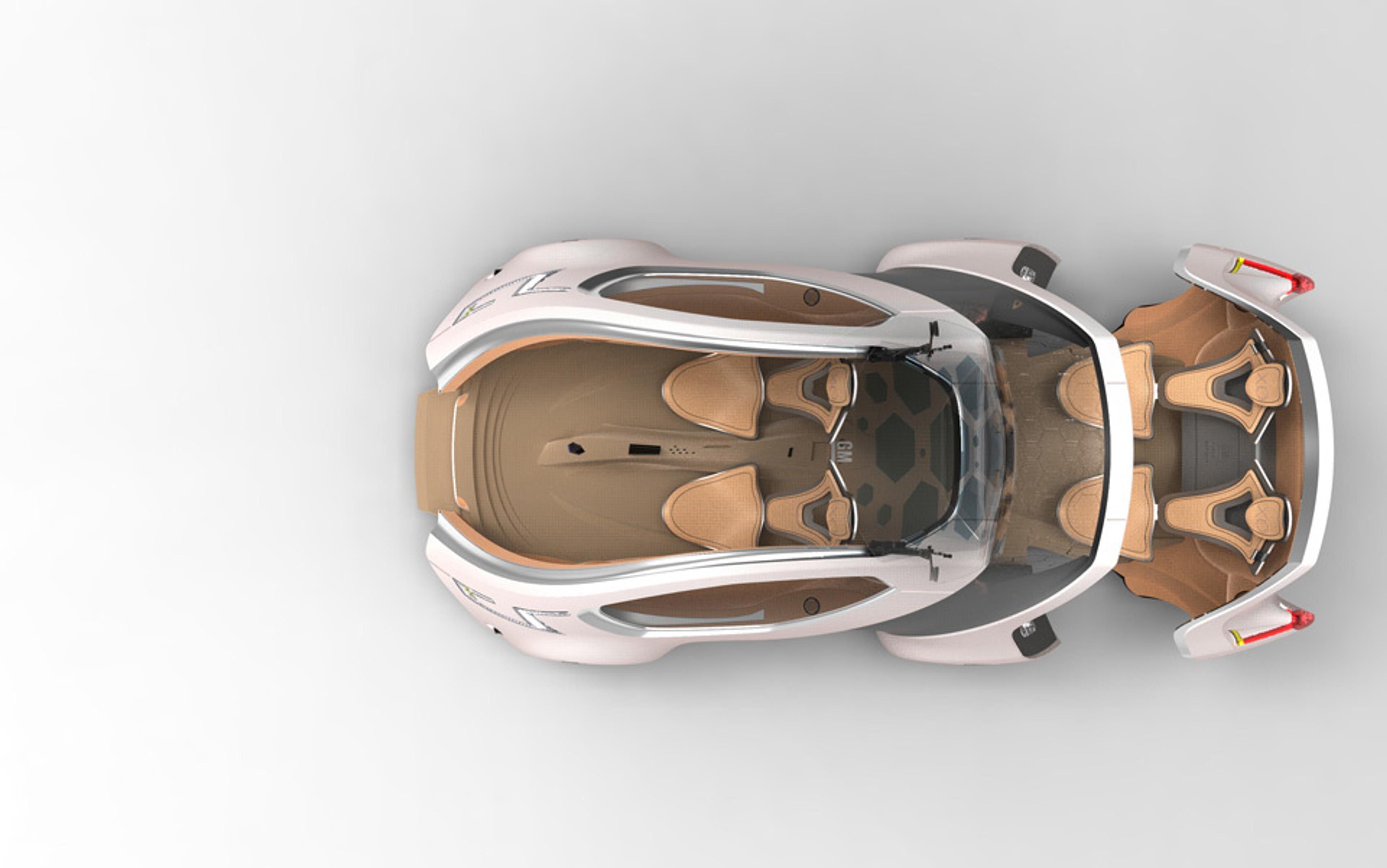

خودروی قابل انعطاف GMXO طراحی شده توسط علی جعفری میتواند بدون راننده حرکت کند. این خودرو بر اساس نیازهای پارک و سرنشینان، قابلیت کشیده شدن یا جمع شدن دارد. عکس با مجوز جنرال موتورز.در حال حاضر، ماشینهایی که قادر به «تفکر» به معنای نزدیک به انسان هستند، هنوز در دنیای علم تخیل باقی ماندهاند. اما سوالی که باید به آن پاسخ دهیم این است که چگونه باید برای ظهور احتمالی آنها آماده شویم. به عنوان مثال، در زمینه تریاژ پزشکی، که در آن اتوماسیون و الگوریتمها نقش مهمی دارند، تصمیمگیریهایی انجام میشود که ریسک و فایده را در میان حوادث انسانی متعادل میکند. با توجه به محدودیت زمان و منابع، ممکن است یک بیمار در آستانه مرگ نسبت به فردی که تنها در حال درد کشیدن است، اولویت بیشتری داشته باشد.

در میدان جنگ، تریاژ میتواند به معنای رها کردن مجروحان باشد، اگر مراقبت از آنها جان دیگران را به خطر بیندازد. در بهداشت عمومی، نگرانیهای قرنطینه و آلودگی میتواند شامل رها کردن چند نفر برای حفاظت از بسیاری دیگر باشد. اینها معضلات باستانی وجود جمعی هستند که فناوری و تحقیقات علمی آنها را به طرز قابل توجهی کارآمدتر، مؤثرتر و مبتنی بر شواهد کردهاند.

اما چه میشود اگر ما نه تنها در حال برنامهریزی رویههای سریعتر در ابزارهای خود باشیم، بلکه از آنها برای تعیین اصول پشت این تصمیمات نیز استفاده کنیم: وزندهی به تریاژ، یا لحظهای که در صورت بروز بحران، درهای یک کارخانه شیمیایی بهطور خودکار بسته میشود؟ در انتهای دیگر این مقیاس، ممکن است بپرسیم: آیا باید تلاش کنیم تا همه زندگیهای انسانی را به طور مساوی ارزشگذاری کنیم و درآمدها و تلاشهای خود را به توزیع عادلانهای که یک هوش مصنوعی انجام میدهد، واگذار کنیم؟

شاید شما در مورد چنین حدسهایی تردید کنید. اما در نهایت، ما همیشه به ماشینها نیاز خواهیم داشت تا ما را از سایر ماشینها محافظت کنند. نیک بستروم، فیلسوف دانشگاه آکسفورد، بر این باور است که باید به این سوال بپردازیم که چگونه میتوانیم به طور موفقیتآمیز به یک چارچوب مرجع بیسابقه منتقل شویم. در مقالهای با عنوان «اخلاق هوش مصنوعی»، بستروم و الیعزر یودکوسکی استدلال میکنند که الگوریتمهای تصمیمگیری پیچیدهتر نه تنها اجتنابناپذیر، بلکه مطلوب نیز هستند، به شرطی که شفاف و قابل

پیشبینی باقی بمانند. اگر خودروی خودران من آماده باشد تا جان من را برای نجات چندین نفر دیگر قربانی کند، این اصل باید از پیش به وضوح مشخص شود. اما در مورد بدترین سناریوها چه؟ وقتی صحبت از اتوماسیون و هوش مصنوعی میشود، حوادثی که در افق ما قرار دارند ممکن است از نوعی باشند که قابل بازیابی نیستند. اگر اشتباه کنید و اولویتهایی را که به شکوفایی انسانی آسیب میزند، در نسل اول ماشینهای هوشمند واقعی نهادینه کنید، ممکن است دیگر هیچ انسانی برای جمعآوری تکههای باقیمانده وجود نداشته باشد. ماشینها طبیعتی ثابت ندارند و هر آنچه که ما به حرکت درآوریم هستند. اگر فقط یک خودروی خودکار کاملاً عملکردی بسازید، الگوی ساخت 1 میلیارد خودرو را خواهید داشت. در نهایت، همه چیز به کارایی برمیگردد و ما باید برای هر ارزشی که بهطور بیرحمانه به نمایندگی از ما دنبال میشود، آماده باشیم.

جامعه از زمانهای بسیار قبل از انقلاب صنعتی از میوههای اتوماسیون بهرهمند شده است و دستاوردها در زمینههای مختلف بسیار زیاد بودهاند. با این حال، اگر سرنوشت ما نوعی عایق وجودی جدید باشد، این به دلیل غلبه بر تاریخ و زمان نخواهد بود، بلکه به این دلیل خواهد بود که ما درگیری را به چیزی فراتر از خودمان واگذار کردهایم.

در نهایت، «خیر عمومی» به هدفی تبدیل میشود که میتوانیم بهطور مستقل از خودمان به حرکت درآوریم، اما هیچ چیز فراتر از ابزارهای درخشان ما وجود ندارد. معیار موفقیت آنها همان چیزی خواهد بود که همیشه بوده است: حوادث عجیب یک زندگی انسانی.

برای مطالعه بیشتر: خطرات هوش مصنوعی

دیدگاهتان را بنویسید